Verständlich erklärt: Was ist Big Data und wofür ist es gut?

Was ist mit Big Data gemeint?

Definition: Die 3 V von Big Data

Volume (Umfang)

Velocity (Geschwindigkeit)

Variety (Vielfalt)

Quellen von Big Data: Woher kommen die Daten?

Beispiele für den Einsatz von Big Data

Beispiel 1: Automobilindustrie

Beispiel 2: Marketing

Beispiel 3: Health Care

Warum ist Big Data wichtig?

Die Funktionsweise von Big-Data-Technologien

Verteilung auf mehrere Systeme

Parallele Verarbeitung

Hohe Skalierbarkeit

Advanced Analytics

Automatisierung

Herausforderungen von Big Data

Die Zukunft von und mit Big Data

Digitale Geräte und das Internet erzeugen riesige Datenmengen. Unternehmen können diese Daten nutzen, um ihre Produkte und Dienstleistungen besser auf den Markt und ihre Kunden auszurichten. Big Data kann so entscheidend zum Unternehmenserfolg beitragen. Doch was versteht man eigentlich unter Big Data? Und wie genau lassen sich die Daten sinnvoll nutzen?

Dieser Artikel erklärt einfach und verständlich, was Big Data ausmacht, woher die vielen Daten kommen und wo sie eingesetzt werden. Du erfährst, warum so viele Unternehmen fleißig Daten sammeln und welche Technologien dafür nötig sind. Wir zeigen auch, welche Herausforderungen es dabei gibt und geben einen Ausblick, welche Rolle Big Data in Zukunft spielen wird.

Was ist mit Big Data gemeint?

Unter Big Data verstehen wir riesige Datenmengen, die hochkomplex und hochdynamisch sind. Sie können mit herkömmlichen Methoden der Datenverarbeitung nicht gespeichert und ausgewertet werden. Das heißt: Ein einzelner Computer kann die Datenmassen nicht bewältigen und gängige Software wie Excel kann sie nicht analysieren. Hierfür werden spezielle Technologien benötigt. Auch für diese Technologien wird häufig der Begriff Big Data verwendet.

Definition: Die 3 V von Big Data

Zur Definition von Big Data wird in der Regel das 3V-Modell genutzt. Der Informatiker Doug Laney beschrieb Anfang der 2000er Jahre drei wesentliche Dimensionen von Big Data:

Volume (Umfang)

Datensätze umfassen oft mehrere Millionen Gigabyte. Man spricht auch von Petabyte (ca. 1 Million Gigabyte) oder Exabyte (ca. 1 Milliarde Gigabyte). Solche riesigen Datenmengen begegnen uns im Alltag selten. Anschaulicher wird es mit diesem Vergleich: Ein Petabyte entspricht etwa 500 Milliarden Textseiten. Man kann sich leicht vorstellen, dass eine normale Festplatte dafür nicht ausreicht. Wegen dieser enormen Menge wird Big Data auch als Massendaten bezeichnet.

Velocity (Geschwindigkeit)

Die Datensätze entstehen in hoher Geschwindigkeit. Und da sie aufgrund ihrer Dynamik schnell wieder an Wert verlieren, müssen sie auch mit hoher Geschwindigkeit übertragen und ausgewertet werden. Einige digitale Geräte können dynamische Datenströme in Echtzeit oder nahezu in Echtzeit verarbeiten.

Variety (Vielfalt)

Große, schnelllebige Datensätze enthalten verschiedene Arten von Daten. Es gibt strukturierte Formate, wie gewöhnliche Tabellen, sowie semi- und unstrukturierte Formate, wie Fotos, Videos oder E-Mails. Die Vielfalt der Datentypen erfordert spezielle Systeme, mit denen die Daten zusammen gespeichert und analysiert werden können.

Im Laufe der Jahre wurde das 3V-Modell um viele weitere Begriffe mit einem V ergänzt, zum Beispiel Veracity (Qualität bzw. Echtheit der Daten) oder Value (Mehrwert der Daten). Die Hauptmerkmale von Big Data sind jedoch laut unterschiedlicher Definitionen immer die enorme Menge, Geschwindigkeit und Vielfalt der Daten.

Quellen von Big Data: Woher kommen die Daten?

Das weltweite Volumen digitaler Daten wächst ungebremst. Jedes Jahr werden riesige Mengen neuer Daten generiert, und das in immer extremeren Dimensionen – schneller, komplexer, mehr. Angesichts der fortschreitenden Digitalisierung ist das kaum verwunderlich. Digitale Geräte, smarte Systeme, Apps und Co. überschwemmen den Markt. Milliarden von Menschen nutzen das Internet und verschiedene digitale Medien. Immer mehr Unternehmen und Verwaltungen durchlaufen digitale Transformationsprozesse. Und die digitale Infrastruktur wird durch innovative Technologien ständig erweitert. Dadurch ergeben sich zahlreiche Datenquellen, zum Beispiel:

Smartphones

Smartwatches

Smarthome-Geräte

Social Media

Suchmaschinen

Streamingdienste

E-Commerce

Das Internet of Things (Internet der Dinge) ist ein gigantisches Netzwerk von Technologien und Softwaresystemen, die über das Internet miteinander verbunden sind und Daten austauschen.

Beispiele für den Einsatz von Big Data

In unserer digitalisierten Welt sind Daten im Prinzip jederzeit und überall verfügbar. Das machen sich Unternehmen, aber auch die Forschung zunutze. Verschiedene Branchen, Abteilungen und gesellschaftliche Bereiche können neue Einsichten aus Big Data gewinnen. Hier einige Beispiele:

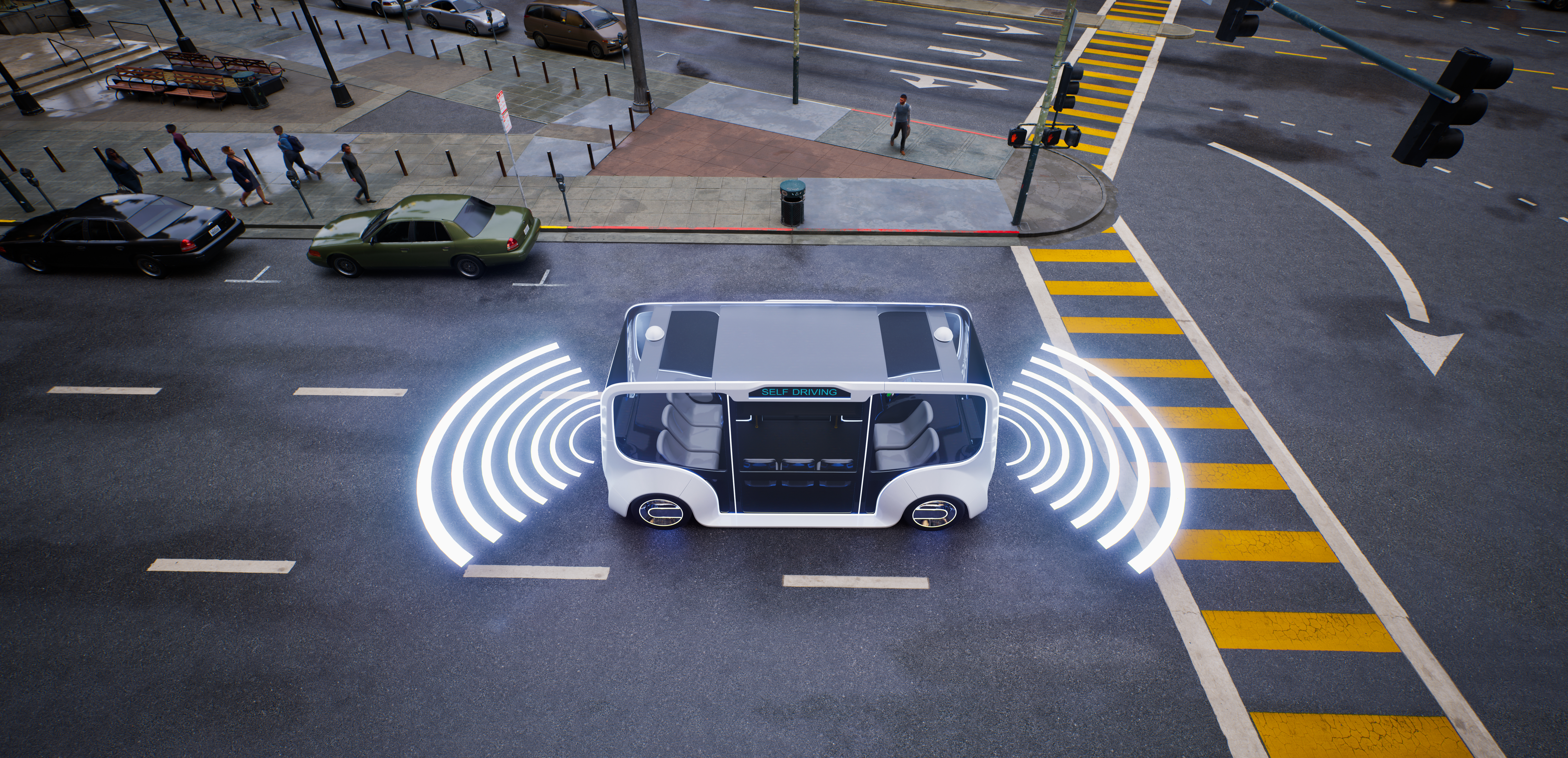

Beispiel 1: Automobilindustrie

Ein wichtiger „Treibstoff“ für automatisiertes und autonomes Fahren sind Daten, und zwar viele. Je selbstständiger sich ein Fahrzeug im Verkehr bewegen soll, desto besser müssen die Algorithmen der integrierten KI-Systeme sein. Grundlage dafür sind Daten aus kilometerlangen Fahrten in Simulationen, auf Testgeländen und schließlich auch im realen Straßenverkehr. So kann die Künstliche Intelligenz unterschiedlichste Szenarien im Straßenverkehr erproben. Diese datenbasierte Fahrschule für das Auto sorgt für eine hohe Sicherheit der Fahrzeuginsassen.

Beispiel 2: Marketing

Kundendaten bereichern das Marketing. Denk zum Beispiel an deine Lieblingsmarke. Welche Informationen gibst du dem Unternehmen über dich? Vielleicht kaufst du im Online-Shop ein. Vielleicht folgst du der Marke in den sozialen Medien und interagierst mit ihren Posts. Vielleicht füllst du Kundenumfragen aus, schreibst Bewertungen oder hast eine Kundenkarte. All das generiert Daten - Daten über dein Kaufverhalten, deine Mediennutzung, deine Vorlieben, deine Markentreue und so weiter. Das Unternehmen kann diese Daten nutzen, um mehr über dich als Kundin oder Kunden zu erfahren und dir personalisierte Informationen über die von dir am häufigsten genutzten Kanäle zukommen zu lassen.

Beispiel 3: Health Care

In der Medizin und im Gesundheitswesen fallen große Mengen an Daten von Patientinnen und Patienten sowie der Allgemeinbevölkerung an, zum Beispiel über Krankenkassen, Gesundheits-Apps oder Suchanfragen zu Symptomen. Sinnvoll genutzt, können diese Daten beispielsweise helfen, die individuelle Versorgung von Patientinnen und Patienten zu verbessern oder wirksame Präventionsangebote zu gestalten.

Warum ist Big Data wichtig?

„Daten sind das neue Öl.“ Dieser Spruch bringt den Big-Data-Trend gut auf den Punkt, denn Daten gelten als Rohstoff der Zukunft. Der digitale Wandel krempelt die Unternehmens- und Arbeitswelt um und digitale Daten werden zur zentralen Ressource. Große Technologiekonzerne bauen ihren Erfolg auf riesigen Datenbeständen auf und auch immer mehr kleine und mittlere Unternehmen wollen das Potenzial von Big Data ausschöpfen.

Dabei kommt es nicht darauf an, so viele Daten wie möglich zu sammeln. Viel wichtiger ist es, die vorhandenen Daten effizient zu nutzen. Indem sie aufbereitet und ausgewertet werden, lassen sich Trends, Muster und Zusammenhänge identifizieren. Das liefert wertvolle Erkenntnisse über Prozesse, Produkte, Märkte und Menschen. Auf dieser Basis können Unternehmen:

Prozesse und Ressourcen besser managen (z. B. Zeit und Kosten sparen)

Produkte optimieren oder aufgrund von Markttrends neu entwickeln

geschäftliche Entscheidungen datengestützt treffen

Nicht nur Unternehmen können von Big Data profitieren. Auch in öffentlichen Bereichen wie der Medizin, Bildung oder Verwaltung können Daten zu mehr Wissen und Fortschritt führen.

Die Funktionsweise von Big-Data-Technologien

Wissen und Fortschritt ergeben sich nicht automatisch aus Big Data. Die Daten müssen effizient gespeichert, verwaltet und vor allem ausgewertet werden. Dazu braucht es spezielle Technologien und Tools. Geeignete Big-Data-Lösungen arbeiten nach diesen Prinzipien:

Verteilung auf mehrere Systeme

Die Daten werden nicht auf einem einzigen Gerät gespeichert und verarbeitet, sondern auf mehrere vernetzte Geräte verteilt. Dies können Computer oder Server in einem Rechenzentrum sein. Eine Remote-Lösung dagegen ist das Cloud Computing. Hier werden die Daten online gespeichert und können bei bestehender Internetverbindung jederzeit und überall abgerufen werden.

Parallele Verarbeitung

Bei Datenmengen im Peta- und Exabyte-Bereich würde es sehr lange dauern, die Daten einzeln nacheinander zu verarbeiten. Um Tempo in die Auswertung zu bringen, werden deshalb sowohl die Daten als auch Teilschritte der Datenanalyse auf mehrere Rechner verteilt. So können die Daten gleichzeitig bzw. parallel verarbeitet werden. Anschließend werden die Teilergebnisse zusammengeführt. Dies ist deutlich schneller als ein sequenzielles Vorgehen.

Hohe Skalierbarkeit

Da die Datenströme sehr dynamisch sind, müssen die Kapazitäten der Big-Data-Infrastruktur ständig angepasst werden. Nur so lassen sich Spitzen oder Einbrüche im Datenfluss effizient abfangen. Ein hochskalierbares System kann genau das leisten: Bei Bedarf werden neue Rechnerressourcen hinzugeschaltet, um seine Größe und Leistung zu erhöhen. Hochskalierbare Speichersysteme für Big Data sind etwa Data Lakes oder NoSQL-Datenbanken, auch nicht-relationale Datenbanken genannt.

Advanced Analytics

Häufigkeitsverteilungen und Korrelationen reichen nicht aus, um Big Data auszuwerten. Komplexere Analysemethoden wie Data Mining oder Künstliche Intelligenz sind erforderlich. Diese können im Bereich der Business Intelligence eingesetzt werden, bei der Unternehmensdaten systematisch analysiert werden. Advanced-Analytics-Methoden erfordern – wie der Name schon vermuten lässt –fortgeschrittene Fähigkeiten. Data Scientists bzw. Datenwissenschaftler:innen bringen dieses Know-how mit. Ihre Aufgabe ist es, aus Big Data Smart Data zu machen und die gewonnenen Informationen verständlich aufzubereiten, zum Beispiel durch Visualisierungen.

Automatisierung

Um die rasant wachsende Datenflut bewältigen zu können, sind zunehmend automatisierte Lösungen gefragt. Schon heute können riesige Datenmengen nicht mehr manuell verwaltet und ausgewertet werden, und das weltweite Datenvolumen steigt jährlich exponentiell an. Vielversprechende Technologien, um den menschlichen Faktor bei der Datenanalyse so weit wie möglich zu reduzieren, sind Künstliche Intelligenz, Machine Learning und Neuronale Netzwerke.

Herausforderungen von Big Data

Wer mit Big Data arbeitet, muss immer auf dem neuesten Stand der Technik sein. Die technische Infrastruktur entwickelt sich ständig weiter und die Methoden der Datenverarbeitung ändern sich. So war zum Beispiel noch vor wenigen Jahren das Framework Apache Hadoop das gängige Big-Data-Ökosystem, um große Datenmengen zu speichern und zu verarbeiten. Inzwischen gibt es Apache Spark und Apache Flink, die eine schnellere Datenverarbeitung ermöglichen.

Eine weitere Herausforderung ist die Datenqualität. Viele Datensätze weisen aufgrund ihrer Komplexität und schnellen Veränderung Dubletten, Lücken oder Fehler auf. Bevor die Daten sauber ausgewertet werden können, müssen sie oft aufwändig bereinigt, aufbereitet und geprüft werden.

Ein häufiger Kritikpunkt in der Debatte um Big Data ist der Datenschutz. Unternehmen sammeln zahlreiche, teils sehr private Informationen über ihre Kundinnen und Kunden. Den Nutzer:innen von Online-Angeboten, Apps oder smarten Geräten ist dabei oft nicht bewusst, welche Daten von wem und zu welchem Zweck genutzt werden. Den Überblick über die eigenen Daten zu behalten, ist angesichts der täglich wachsenden Informationsflut durch digitale Medien und das Internet eine große Herausforderung für jede und jeden.

Die Zukunft von und mit Big Data

Daten werden auch in Zukunft ein wertvolles Gut in unserer Informations- und Wissensgesellschaft sein. Die Menge der generierten Daten nimmt jährlich rapide zu und der Markt für Big-Data- und KI-Technologien wächst ungebremst. Machine-Learning-Anwendungen und Lösungen, die Daten in Echtzeit verarbeiten können, liegen derzeit voll im Trend.

Aufgrund ihres hohen Potenzials, Wissen zu generieren und Prozesse zu automatisieren, wirken Daten und Big Data Analytics als wesentliche Treiber für Industrie 4.0. Themen wie Datenschutz und Informationssicherheit stehen dabei weiterhin ganz oben auf der Agenda. Auch Phänomene wie Deepfakes oder Diskriminierung durch KI werden zunehmend in der Öffentlichkeit diskutiert.

Big Data und Künstliche Intelligenz sind also nicht nur für Datenexpertinnen und KI-Entwickler interessant! Ein vertieftes Grundverständnis vermittelt dir unser E-Learning „Big Data – Die Welt der Daten verstehen“.